Member Content

Ich wollte schon länger daran arbeiten, n8n mit Langdock zu verbinden . Der Gedanke reizte mich einfach: Komplexe AI-Workflows mit zwei deutschen Firmen abzubilden, die ihre Daten in der EU hosten und hohe Compliance-Standards bieten. Das ist der „Holy Grail“ für viele Use Cases und Unternehmen hierzulande.

Vor ca. einer Woche habe ich dann – wie man das als guter ITler so macht – durch die Dokumentation von Langdock gestöbert. Dabei ist mir eine interessante Sache aufgefallen: Man kann die OpenAI Library laden und Langdock als Backend verwenden.

Mein Gedanke: Wenn das mit der Library funktioniert, sollte das eigentlich auch mit n8n klappen.

Gesagt, getan. Verbunden – grüner Balken – Boom, Connection steht. Ich konnte nicht glauben, dass es wirklich so einfach ist.

Spoiler: War es auch nicht.

Nach meinem initialen Enthusiasmus folgte erstmal die Ernüchterung. Nichts funktionierte, alles voller Fehlermeldungen. Nach der Analyse der Logs stellte sich heraus: Cloudflare war genau in diesem Moment down. Timing ist alles. Aber nach ein paar Stunden Warten hatte ich dann wirklich eine stabile Verbindung, über die mein n8n Agent mit Langdock sprechen konnte.

Bisher habe ich zu der Art der Verbindung online noch nichts gefunden. Auch die meisten KIs waren recht ratlos. Da ich nach meinem letzten Artikel öfter gefragt wurde, wie ich das genau gebaut habe, gibt es hier das Tutorial dazu.

Das Setup an sich ist relativ simpel, wenn man weiß, wo man klicken muss.

Wenn man es nicht weiß kann ich aus eigener Erfahrung sagen, braucht man etwas Zeit.

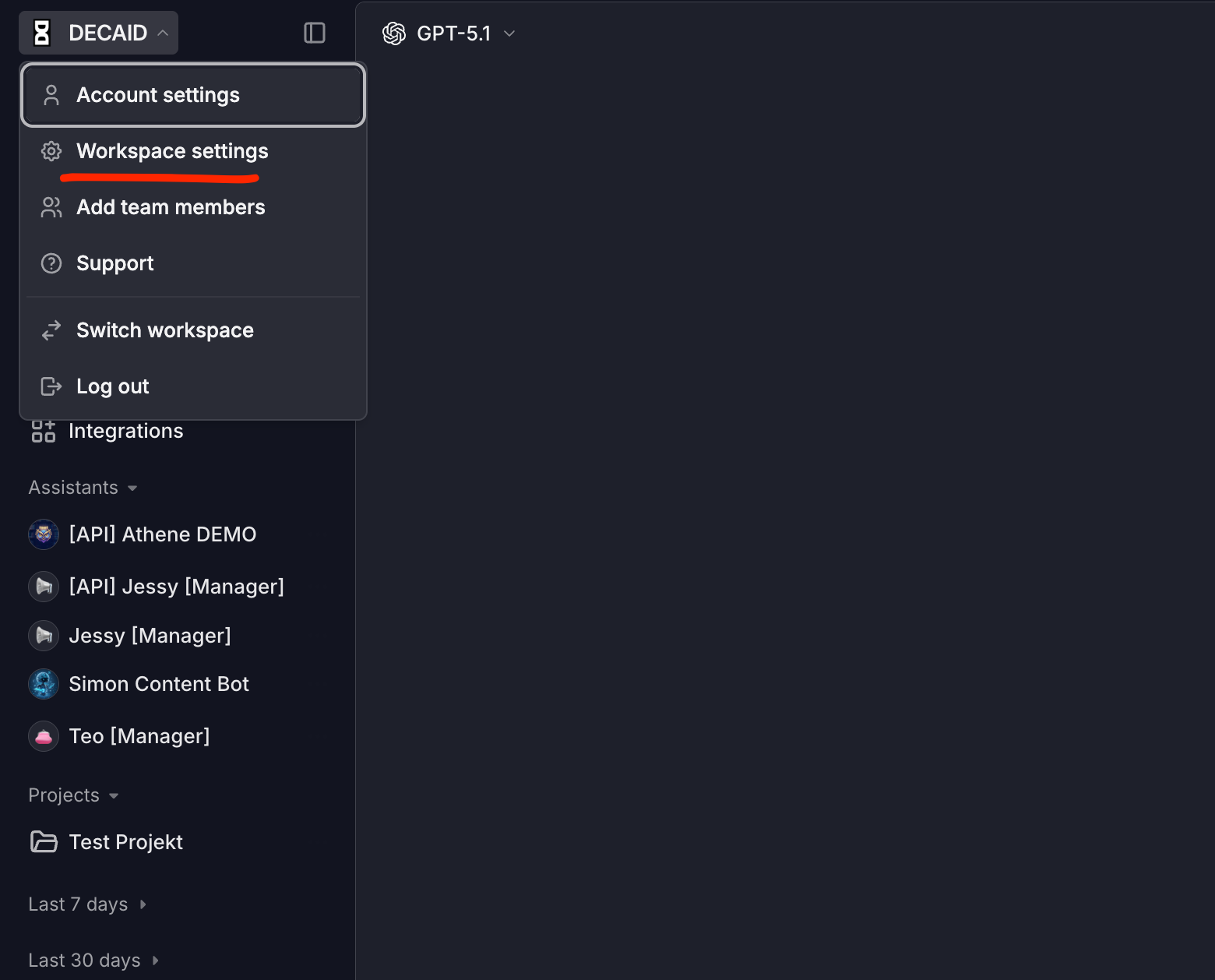

Zuerst benötigen wir einen API Key von Langdock.

Dafür gehen wir unter Workspace Settings:

Dann unter API zu Create API Key :

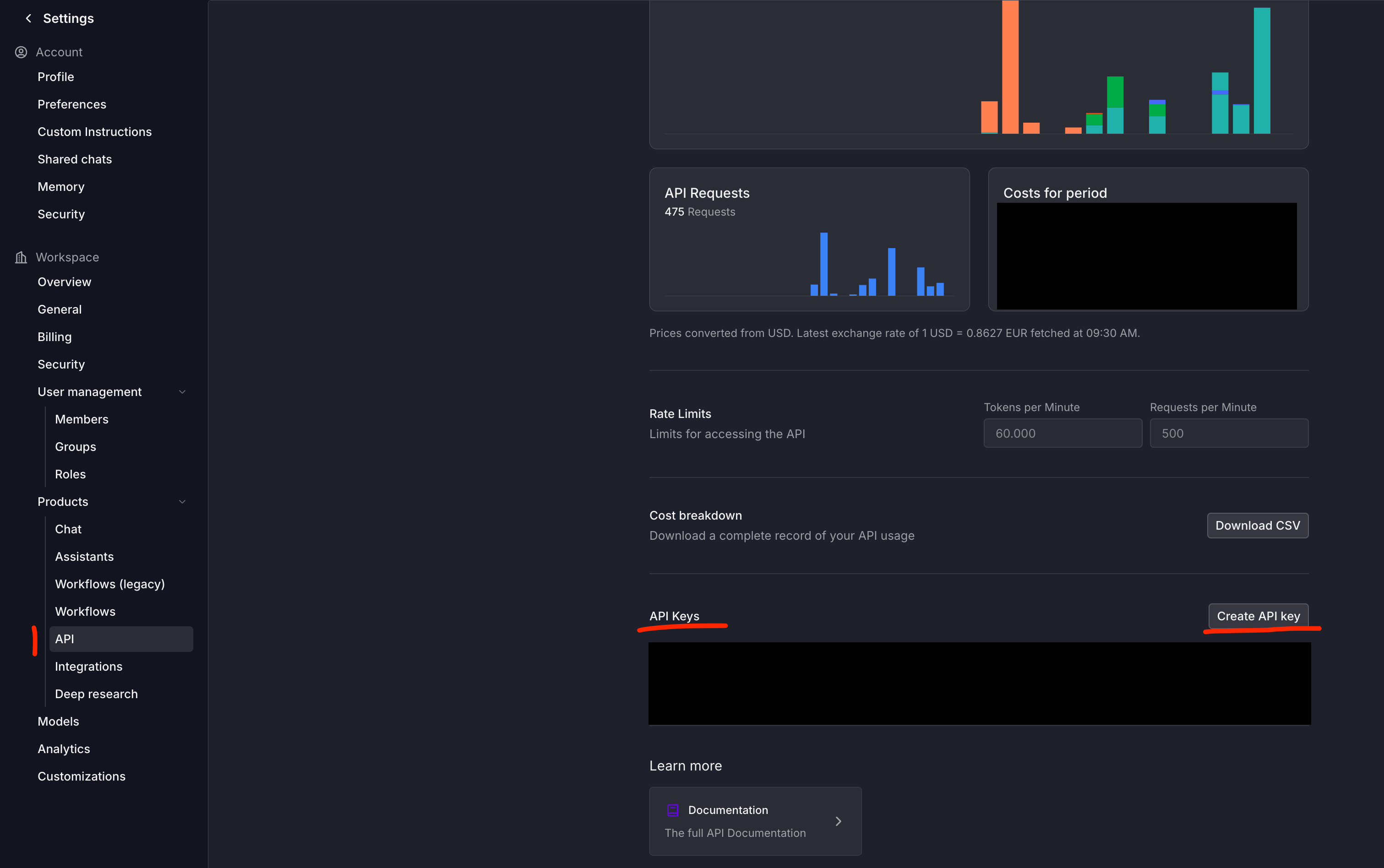

Wir geben dem Key einen Namen und setzen die Laufzeit sowie die Berechtigungen.

💡 Tipp: Ich stelle die Laufzeit bzw. Ablaufzeit auf „Never“, da ich verhindern möchte, dass meine n8n Workflows plötzlich wegen eines abgelaufenen Schlüssels stoppen. Das sollte natürlich je nach Firmen-Policy oder persönlicher Präferenz angepasst werden.

Beim Key Scope gebe ich bis auf „Usage Export API“ alle Berechtigungen, um flexibel alle Services nutzen zu können.

Dann erstellen wir den Schlüssel.

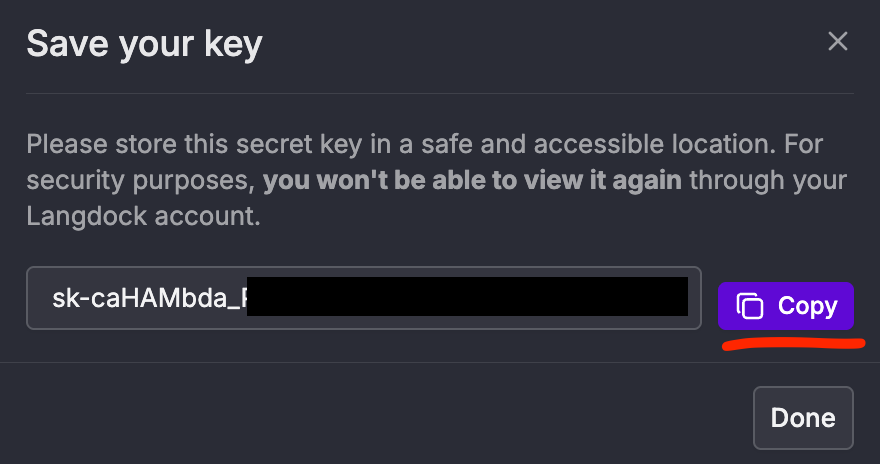

Wichtig: Speichere den Schlüssen an einem sicheren Ort (z. B. im Passwortmanager). Nach dem Schließen des Fensters wird der Key nicht mehr vollständig angezeigt.

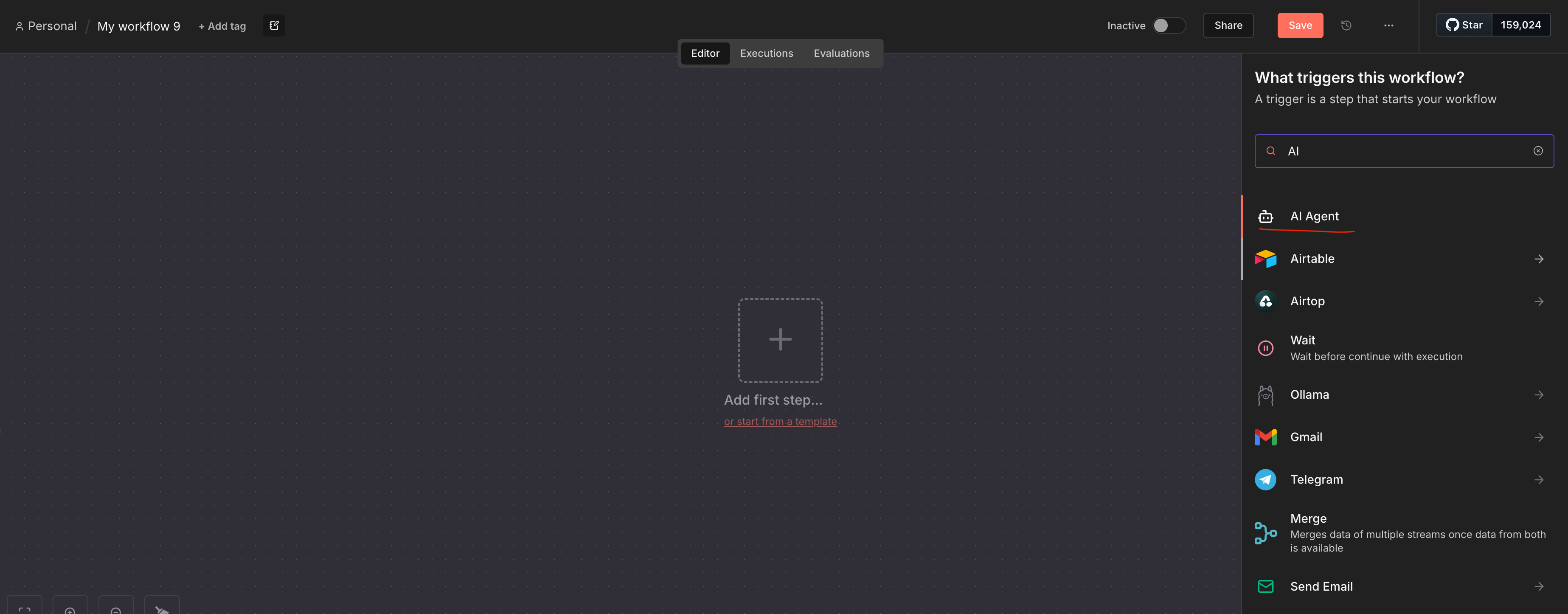

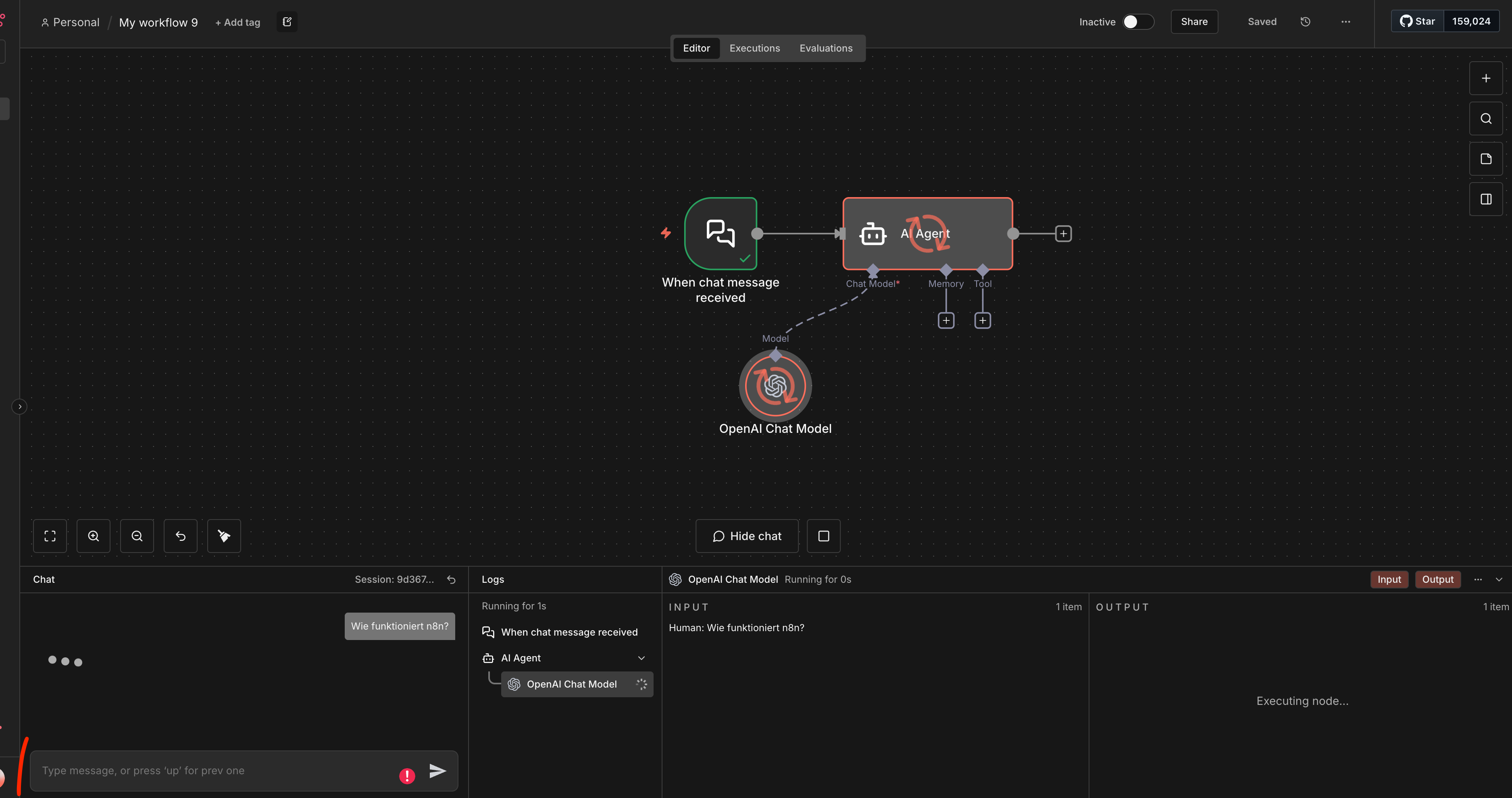

In n8n suchen wir nach dem AI Agent und erstellen einen neuen Node. Das Agent-Fenster können wir vorerst schließen.

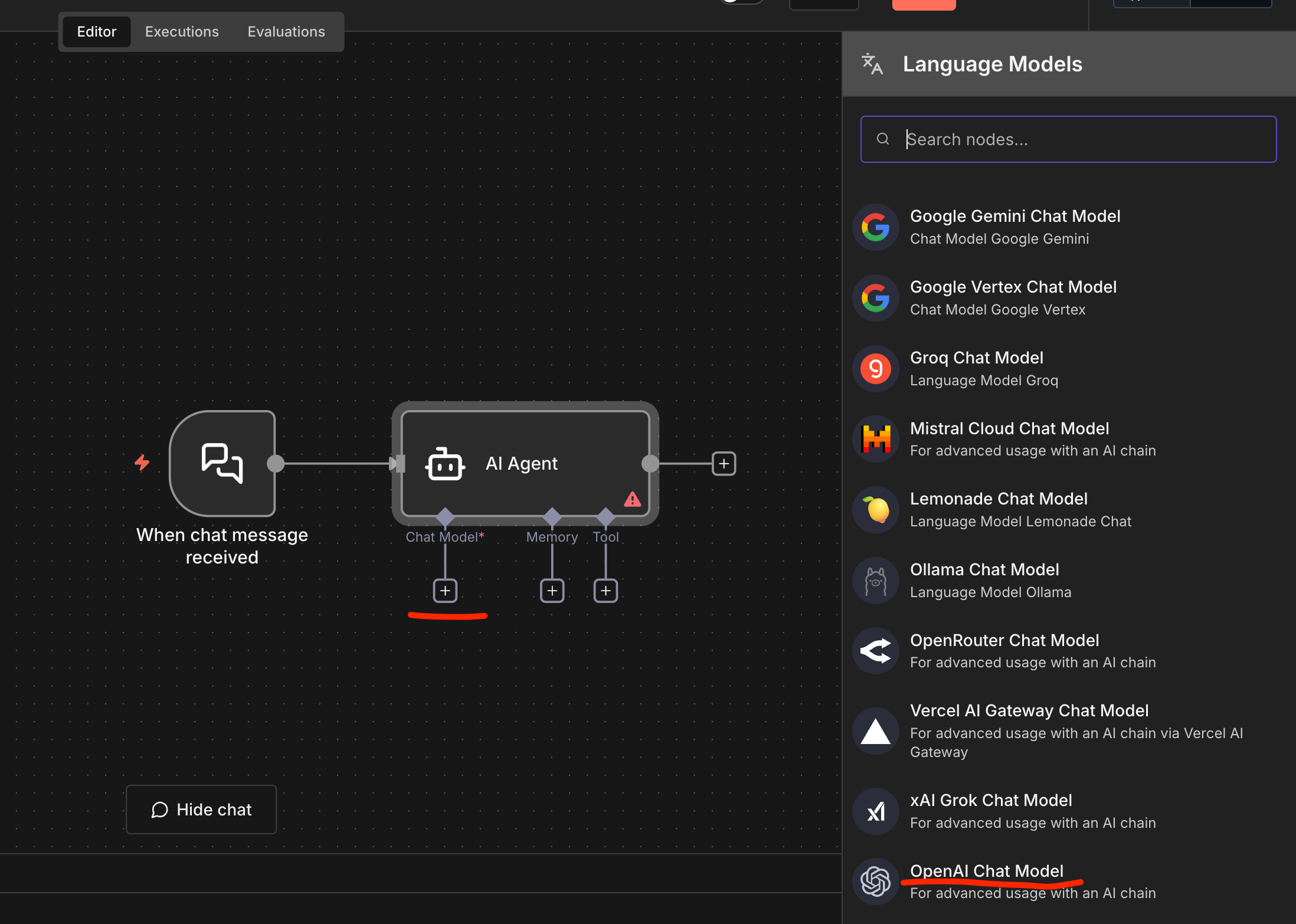

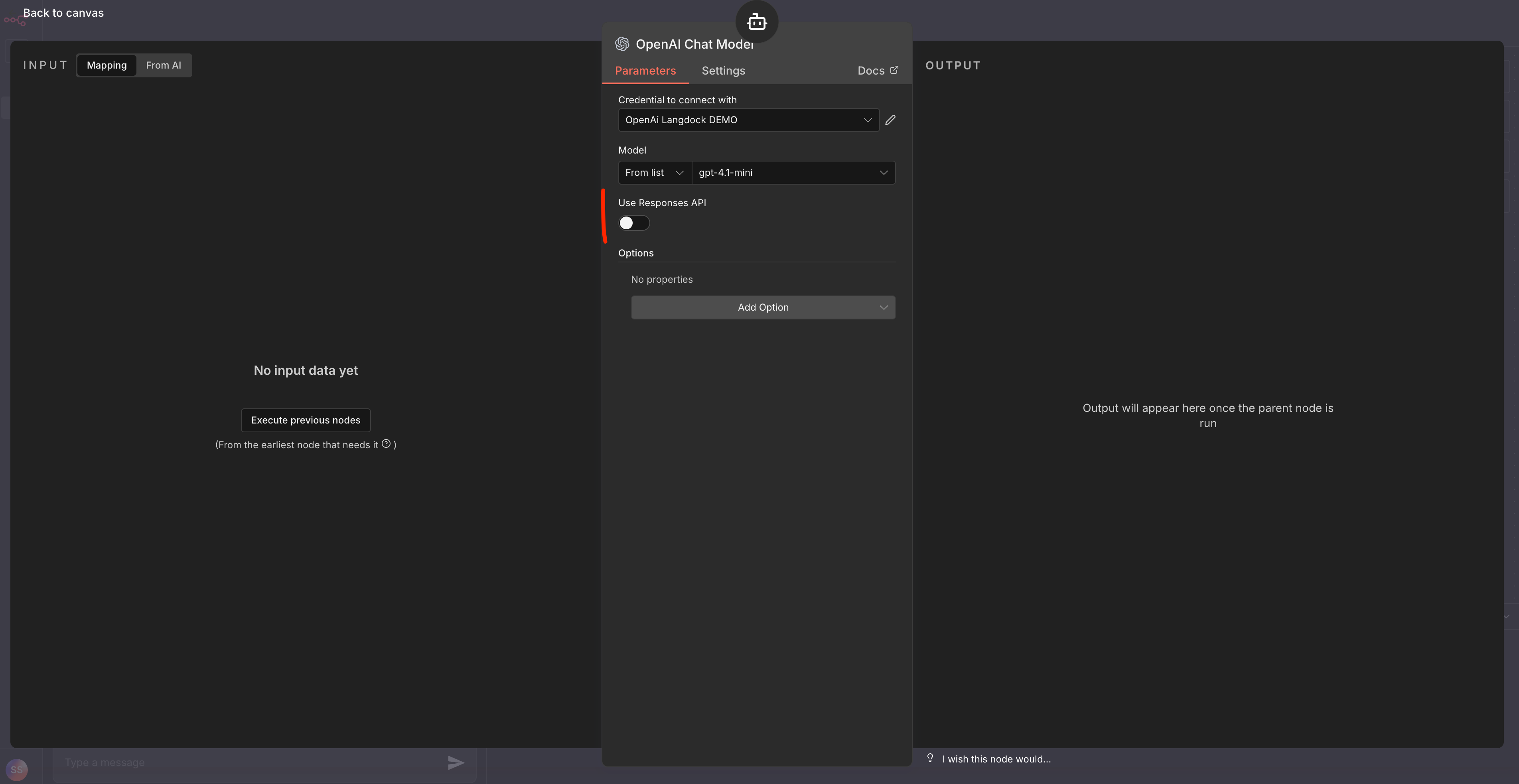

Anschließend wählen wir als Chat Model das OpenAI Chat Model aus.

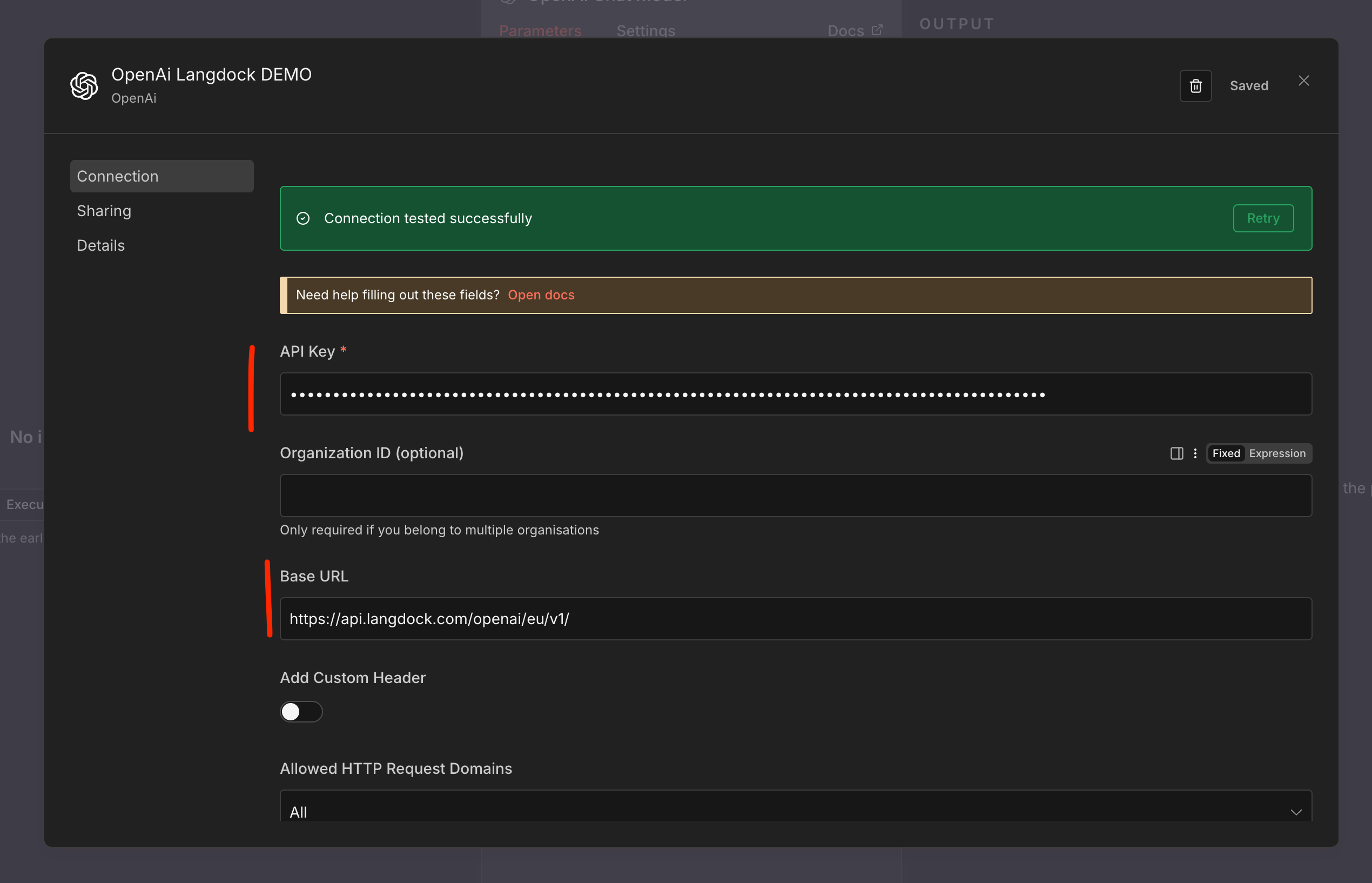

❗️ Hier kommt der entscheidende Teil:

Wenn wir jetzt auf „Save“ klicken, sollten wir den grünen Balken bekommen: Die Verbindung steht!

Damit alles reibungslos läuft, müssen wir noch eine Einstellung anpassen: Die in n8n relativ neue Response API muss deaktiviert werden. Diese ist bei Langdock aktuell (noch) nicht verfügbar, was sonst beim ersten Request zu einem Fehler führt.

Jetzt sollten wir im Drop-Down-Menü alle Modelle sehen, die uns Langdock zur Verfügung stellt.

Nun können wir die Chat Node öffnen und unsere erste Anfrage stellen.

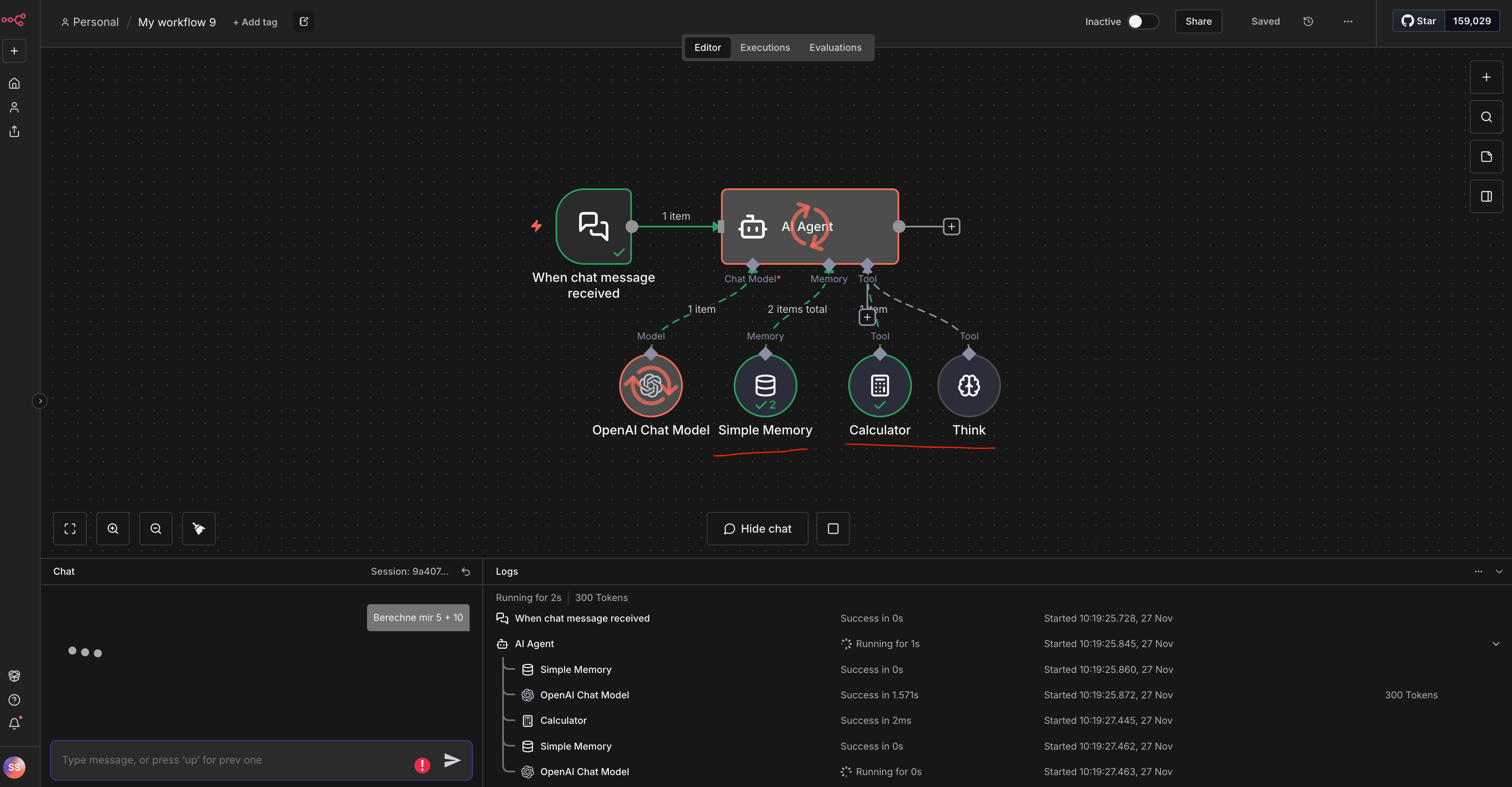

Auch die Nutzung von Memory und Tools funktioniert in meinen Tests problemlos.

Da Langdock keinen vollständigen 1:1-Nachbau der OpenAI API bietet, sondern nur die wichtigsten Endpoints kompatibel macht, funktionieren manche Features nur eingeschränkt oder gar nicht. Hier sind die Stolpersteine, auf die ich gestoßen bin:

Ist es die perfekte Lösung? Nein.

Manche Funktionen sind nicht verfügbar, und da diese Lösung nicht offiziell zwischen n8n und Langdock abgestimmt ist, nutzen wir hier quasi einen „Kompatibilitäts-Hack“. Es kann sein, dass Teile davon in zukünftigen Updates Anpassungen benötigen.

Aber: Für alle, die eine einfache Lösung suchen, um Langdock und n8n zu verbinden und dabei keine hochkritischen Business-Prozesse abbilden, ist es ein genialer Einstieg. Wir setzen es zum Teil bereits in Production ein, und es läuft stabil. Ein Vorteil von n8n ist zudem, dass bei Updates existierende Workflows meist auf den alten Node-Versionen bleiben und nicht zwangsaktualisiert werden.

Für Fälle, in denen wir Business Critical Prozesse abbilden, setzen wir auf direkte API Calls an Langdock via HTTP Nodes.

Wenn euch das interessiert oder ihr Fragen zur Umsetzung habt, schreibt mir gerne auf LinkedIn dann schreibe ich dazu auch noch einen Artikel!

.svg)

.svg)

0 Comments

Login or Register to Join the Conversation

Create an AccountLog in